用于真实3D场景高保真全息图采集的实时全息相机

导读

全息3D显示技术是近年来的研究热点,其无辐辏冲突、无视觉疲劳的特性吸引了诸多研究者的关注。目前,全息3D显示技术的报道大多围绕虚拟3D场景,这是由于真实3D场景的采集难度大且采集速度慢。此外,全息3D显示依赖于相干光的照明,在重建过程中不可避免的引入了散斑噪声。目前,真实3D场景的全息图的实时生成和高保真重建仍难以实现。

近日,北京航空航天大学王琼华教授团队与上海理工大学庄松林院士和张大伟教授团队合作,提出了一款新型全息相机,用于实时获取真实3D场景的高保真全息图。该全息相机的采集端采用了搭载弹力膜液体透镜的液体相机,计算端使用了一种焦点堆栈网络(FS-Net)。该工作实现了真实3D场景的实时非相干采集和实时高保真全息图计算。所研制的全息相机突破了现有全息3D显示技术中真实3D场景采集困难、全息再现像质量低和离焦模糊不正确的瓶颈问题。相关成果以“Real-time holographic camera for obtaining real 3D scene hologram”为题发表在国际顶尖学术期刊Light: Science & Applications上。

研究背景

全息3D显示被认为是理想的3D显示方式。然而,由于真实3D场景的拍摄和全息图的编码需要耗费大量时间,因此,真实3D场景的全息实时显示仍无法实现。虽然研究者利用电润湿液体透镜完成了真实3D场景的快速拍摄,然而电润湿液体透镜的变焦响应时间约为100毫秒,难以满足实时拍摄真实3D场景的需求。此外,全息图的计算时间随着数据量的增加而显著增长,虽然近年来,研究人员提出了基于深度学习的全息图计算方法,有效加快了全息图的计算速度并提高了全息3D显示的质量。然而,这些方法的全息再现像与真实3D场景的离焦模糊往往是不匹配的。如何实现真实3D场景的实时拍摄和高保真全息重建是全息显示领域待解决的难题。

创新研究

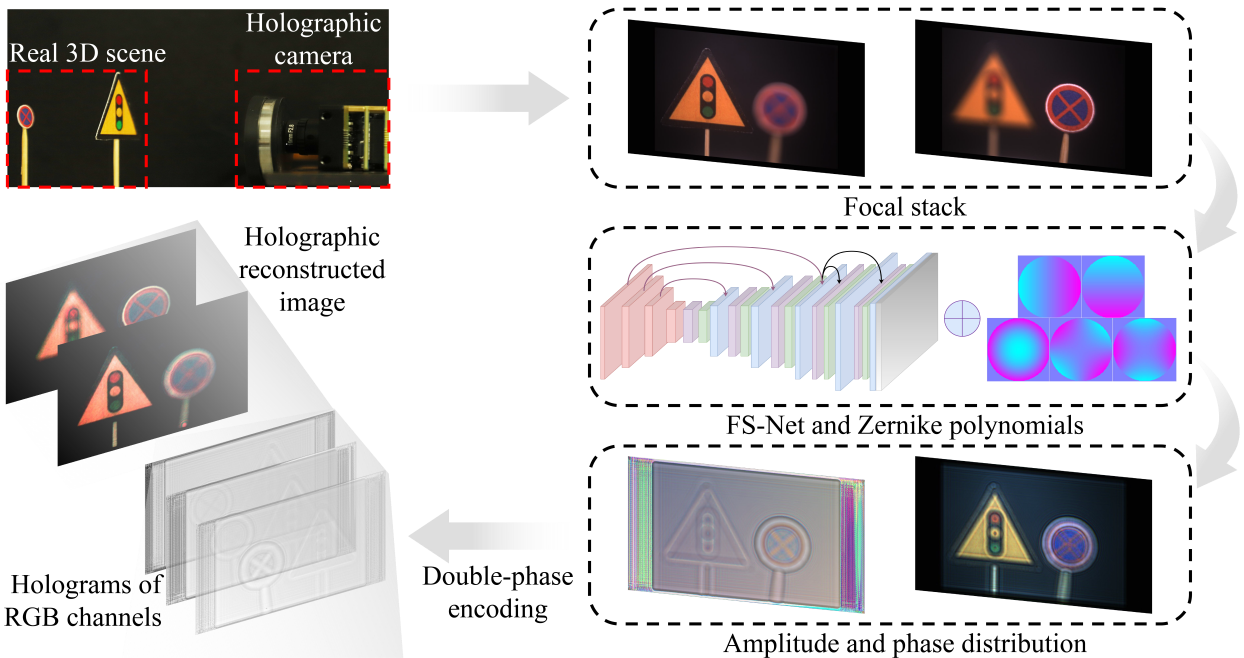

针对上述问题,研究人员提出了一种用于实时获取真实3D场景的高保真全息图的全息相机。如图1所示,在全息相机的采集端,研究人员设计了基于弹力膜液体透镜的液体相机,在音圈电机的驱动下,液体相机能够在15毫秒内进行快速变焦拍摄。在计算端,研究人员提出了一种基于FS-Net的全息图实时生成方法。为了解决全息再现像的模糊与真实3D场景的模糊不匹配的问题,FS-Net中使用了基于Zernike多项式的像差补偿方法。将液体相机拍摄的焦点堆栈输入到FS-Net后,FS-Net计算全息图的时间仅需13毫秒。全息重建实验结果表明,全息再现像的峰值信噪比达到了40dB,从真实3D场景的拍摄到全息3D显示的时间仅需28毫秒。所提出的全息相机实现了真实3D场景的实时采集和高保真全息重建。

图1 全息相机的概念图

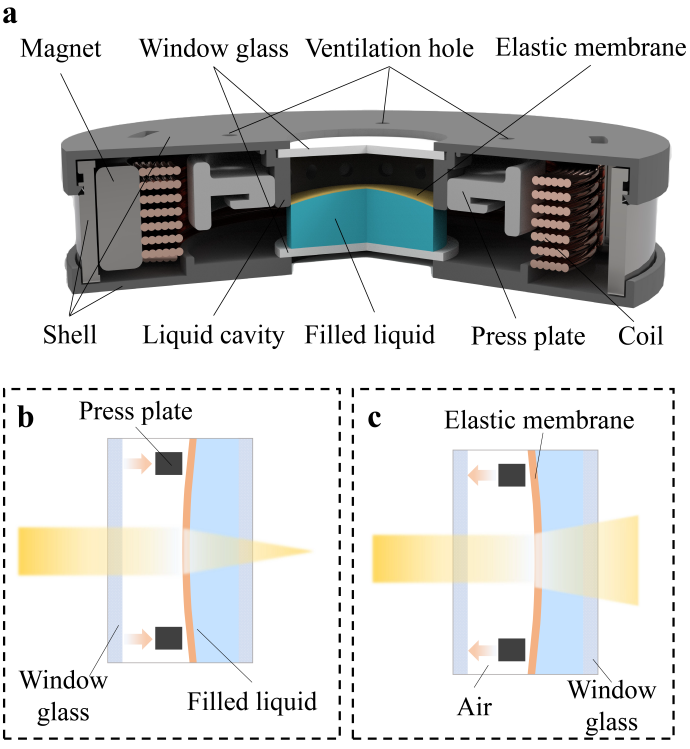

全息相机中的核心元件是弹力膜液体透镜,如图2a所示。弹力膜液体透镜主要由外壳、两片玻璃窗、压板、液腔、磁铁、线圈、弹力膜、填充液体和若干通气孔组成。为了使弹力膜液体透镜的响应速度足够快,研究人员使用高折射率填充液体材料和特殊的弹力膜控制组件,将弹力膜液体透镜的变焦响应时间缩短至15毫秒。当施加不同的驱动电压时,弹力膜液体透镜的面型会在安培力的作用下发生改变。图2b和图2c分别是弹力膜液体透镜在会聚和发散状态下的示意图。

图2 弹力膜液体透镜的结构和效果示意图:a弹力膜液体透镜的结构;b弹力膜液体透镜为会聚状态时的效果; c弹力膜液体透镜为发散状态时的效果

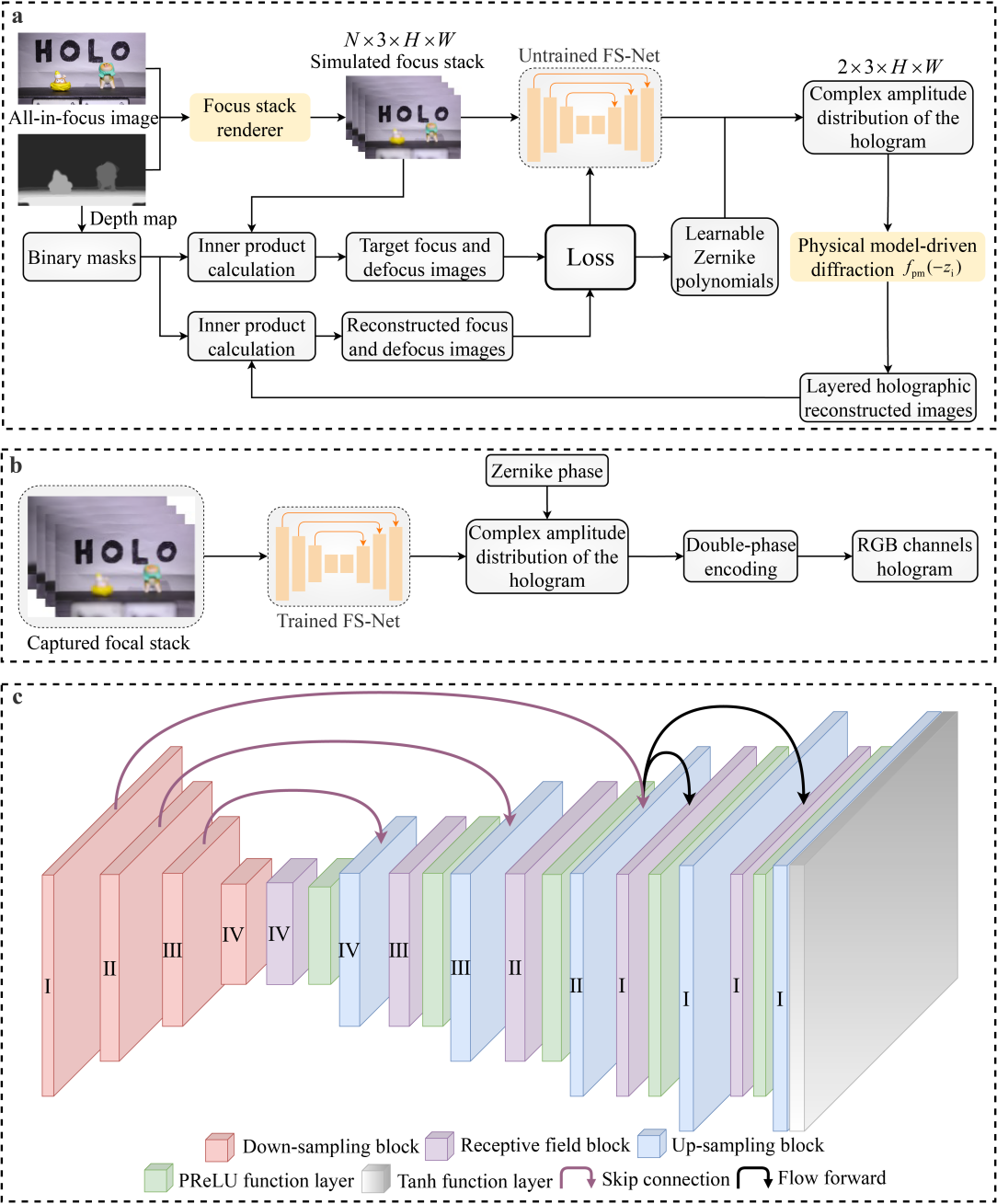

FS-Net训练和生成全息图的流程图如图3所示。与传统的基于深度学习的全息图计算方法不同,FS-Net以真实3D场景的焦点堆栈为输入,并在全息图的训练过程中使用了焦点堆栈渲染器和可学习的Zernike多项式。如图3a所示,首先,利用焦点堆栈渲染器将真实3D场景的全聚焦图和深度图处理成焦点堆栈。接着,利用未训练的FS-Net输出焦点堆栈的复振幅分布。然后,利用物理衍射模型将复振幅分布进行反向传播,得到多层全息再现像。随后,根据分层数和深度图计算多个二值掩膜,并分别计算二值掩膜与焦点堆栈和多层全息再现像的内积,进而得到目标聚焦和离焦像、重建的聚焦和离焦像。最后,计算目标聚焦和离焦像与重建的聚焦和离焦像之间的损失函数,并优化可学习的Zernike多项式和FS-Net中的参数。重复上述步骤,当网络迭代到固定次数时,FS-Net的训练就会停止。图3b是训练好的FS-Net生成全息图的流程图。将液体相机拍摄的焦点堆栈输入到训练好的FS-Net中,输出焦点堆栈的复振幅分布。在使用Zernike相位补偿复振幅分布后,利用双相位编码方法即可获得焦点堆栈的高保真全息图。

图3 FS-Net训练和生成全息图的流程图

论文信息

该研究成果以“Real-time holographic camera for obtaining real 3D scene hologram”为题在线发表在Light: Science & Applications。

论文地址:

新闻稿摘要

北京航空航天大学王琼华教授团队与上海理工大学庄松林院士和张大伟教授团队合作提出了一款新型的全息相机,用于实时获取真实3D场景的高保真全息图。该全息相机的采集端采用了搭载弹力膜液体透镜的液体相机,计算端使用了一种FS-Net,实现了真实3D场景的实时非相干采集和实时高保真全息图计算。所研制的全息相机突破了现有全息3D显示技术中真实3D场景采集困难、全息再现像质量低和离焦模糊不正确的瓶颈问题,有望应用于3D显示和3D测量等领域。

封面图